Plugin GPT của bên thứ ba có thể khiến người dùng bị chiếm đoạt tài khoản

Theo nghiên cứu mới từ Salt Labs (Mỹ), các lỗ hổng bảo mật được tìm thấy trực tiếp trong ChatGPT và hệ sinh thái này có thể cho phép kẻ tấn công cài đặt các plugin độc hại trong khi không có sự đồng ý của người dùng và chiếm đoạt tài khoản trên các trang web bên thứ ba như GitHub.

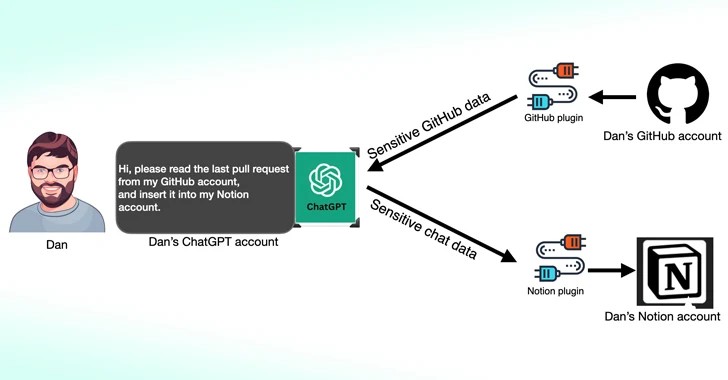

Các plugin ChatGPT là các công cụ được thiết kế để chạy trên mô hình ngôn ngữ lớn (LLM) với mục đích truy cập thông tin cập nhật, thực hiện các tính toán hoặc truy cập các dịch vụ của bên thứ ba.

OpenAI cũng đã giới thiệu GPTs là phiên bản riêng của ChatGPT được thiết kế riêng cho các trường hợp cụ thể, đồng thời giảm sự phụ thuộc vào dịch vụ của bên thứ ba. Kể từ ngày 19/3/2024, người dùng ChatGPT sẽ không thể cài đặt plugin mới hoặc tạo cuộc trò chuyện mới bằng các plugin hiện có nữa.

Một trong những lỗ hổng được Salt Labs phát hiện liên quan đến việc khai thác luồng hoạt động OAuth (OAuth workflow) để đánh lừa người dùng cài đặt một plugin bất kỳ bằng cách lợi dụng việc ChatGPT không xác thực xem có phải người dùng thực sự đã bắt đầu cài đặt plugin hay không. Điều này có thể cho phép kẻ tấn công chặn và lấy cắp tất cả dữ liệu được chia sẻ bởi nạn nhân, có thể chứa thông tin độc quyền.

Công ty an ninh mạng này cũng phát hiện ra các vấn đề với PluginLab mà tin tặc có thể lợi dụng để thực hiện các cuộc tấn công chiếm đoạt tài khoản mà không cần nhấp chuột, cho phép chúng giành quyền kiểm soát tài khoản của tổ chức trên các trang web của bên thứ ba như GitHub và truy cập vào kho mã nguồn của họ.

Nhà nghiên cứu bảo mật Aviad Carmel giải thích rằng "Điểm cuối" 'auth.pluginlab[.]ai/oauth/authorized' không yêu cầu xác thực, điều đó có nghĩa là kẻ tấn công có thể chèn một memberId khác (Id của nạn nhân) và lấy mã (code) đại diện cho nạn nhân. Từ đó, kẻ tấn công có thể sử dụng ChatGPT và truy cập GitHub của nạn nhân”.

MemberId của nạn nhân có thể được lấy bằng cách truy vấn API "auth.pluginlab[.]ai/members/requestMagicEmailCode". May mắn, không có dấu hiệu nào cho thấy dữ liệu của người dùng đã bị xâm phạm bởi lỗ hổng này.

Cũng được phát hiện trong một số plugin, bao gồm Kesem AI là lỗi thao túng chuyển hướng OAuth có thể cho phép kẻ tấn công lấy cắp thông tin xác thực tài khoản được liên kết với chính plugin đó bằng cách gửi một liên kết độc hại cho nạn nhân.

Cuộc tấn công mới nhắm vào trợ lý ảo AI

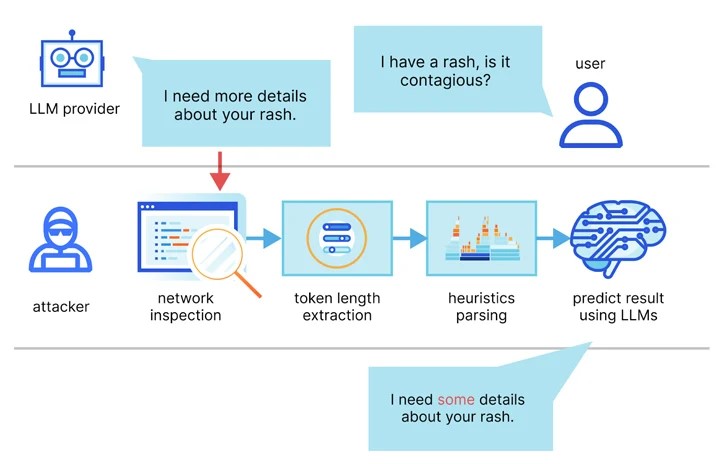

Một nhóm học giả từ Đại học Ben-Gurion và Phòng thí nghiệm nghiên cứu tấn công AI (Isarel) cho biết: “LLM tạo và gửi phản hồi dưới dạng một loạt mã thông báo với mỗi mã thông báo được truyền từ máy chủ đến người dùng khi nó được tạo. Trong khi quá trình này được mã hóa, việc truyền mã thông báo tuần tự sẽ hiển thị một kênh kề mới: kênh kề có độ dài mã thông báo. Mặc dù đã mã hóa, kích thước của các gói có thể tiết lộ độ dài của mã thông báo, có khả năng cho phép những kẻ tấn công trên mạng suy ra thông tin nhạy cảm và bí mật được chia sẻ trong các cuộc trò chuyện riêng tư của trợ lý AI".

Điều này được thực hiện bằng một cuộc tấn công suy luận mã thông báo được thiết kế để giải mã các phản hồi trong lưu lượng được mã hóa bằng cách đào tạo mô hình LLM có khả năng dịch các chuỗi có độ dài mã thông báo thành các đối tác có ý nghĩa bằng ngôn ngữ tự nhiên của chúng (tức là văn bản gốc).

Nói cách khác, ý tưởng cốt lõi là chặn các phản hồi trò chuyện trong thời gian thực với nhà cung cấp LLM, sử dụng tiêu đề gói mạng để suy ra độ dài của mỗi mã thông báo, trích xuất và phân tích các phân đoạn văn bản, đồng thời tận dụng LLM tùy chỉnh để suy ra phản hồi.

Hai điều kiện tiên quyết chính để thực hiện cuộc tấn công là ứng dụng trò chuyện AI chạy ở chế độ phát trực tuyến và tin tặc có khả năng nắm bắt lưu lượng mạng giữa ứng dụng khách và chatbot AI.

Để chống lại tính hiệu quả của cuộc tấn công kênh kề, các công ty phát triển trợ lý AI nên áp dụng phần đệm ngẫu nhiên để che dấu độ dài thực tế của mã thông báo, truyền mã thông báo theo nhóm lớn hơn thay vì riêng lẻ và gửi phản hồi hoàn chỉnh cùng một lúc, thay vì trong một thời trang theo từng mã thông báo.

Quốc An

(Theo thehackernews.com)