Phát hiện lỗ hổng trong Replicate AI làm lộ mô hình và dữ liệu của khách hàng

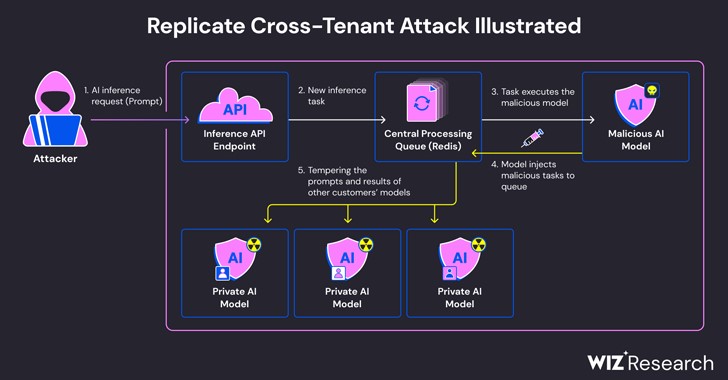

Minh họa cuộc tấn công

Theo báo cáo được công bố vào cuối tháng 5 của công ty bảo mật đám mây Wiz, việc khai thác lỗ hổng này sẽ cho phép truy cập trái phép vào các lời nhắc và kết quả của AI của tất cả khách hàng trên nền tảng của Replicate.

Vấn đề bắt nguồn từ thực tế là các mô hình AI thường được đóng gói ở các định dạng cho phép thực thi mã tùy ý mà kẻ tấn công có thể sử dụng để thực hiện các cuộc tấn công giữa nhiều người thuê bằng một mô hình độc hại.

Replicate sử dụng một công cụ nguồn mở có tên Cog để chứa và đóng gói các mô hình học máy mà sau đó có thể được triển khai trong môi trường tự lưu trữ hoặc để Replicate.

Wiz cho biết họ đã tạo một vùng chứa Cog giả mạo và tải nó lên Replicate, cuối cùng sử dụng nó để thực thi mã từ xa trên cơ sở hạ tầng của dịch vụ với các đặc quyền nâng cao.

Các nhà nghiên cứu bảo mật Shir Tamari và Sagi Tzadik cho biết: “Chúng tôi nghi ngờ kỹ thuật thực thi mã này là một mô hình, trong đó các công ty và tổ chức chạy các mô hình AI từ các nguồn không đáng tin cậy, mặc dù những mô hình này là mã có khả năng độc hại”.

Kỹ thuật tấn công do công ty nghĩ ra sau đó lợi dụng kết nối TCP đã được thiết lập sẵn được liên kết với phiên bản máy chủ Redis trong cụm Kubernetes được lưu trữ trên Google Cloud Platform để đưa vào các lệnh tùy ý.

Hơn nữa, với việc máy chủ Redis tập trung được sử dụng làm nhiều yêu cầu của khách hàng và phản hồi của họ, nó có thể bị lạm dụng để tạo điều kiện cho các cuộc tấn công của nhiều người thuê bằng cách giả mạo quy trình nhằm chèn các tác vụ lừa đảo có thể ảnh hưởng đến kết quả của các máy chủ khác.

Những thao tác lừa đảo này không chỉ đe dọa tính toàn vẹn của các mô hình AI mà còn gây ra rủi ro đáng kể cho tính chính xác và độ tin cậy của các kết quả đầu ra do AI điều khiển.

Các nhà nghiên cứu cho biết: “Kẻ tấn công có thể đã truy vấn các mô hình AI riêng của khách hàng, có khả năng tiết lộ kiến thức độc quyền hoặc dữ liệu nhạy cảm liên quan đến quá trình đào tạo mô hình. Ngoài ra, việc chặn lời nhắc có thể làm lộ dữ liệu nhạy cảm, bao gồm cả thông tin nhận dạng cá nhân (PII)”.

Tiết lộ này được đưa ra hơn một tháng sau khi Wiz nêu chi tiết các rủi ro hiện đã được vá trong các nền tảng như Hugging Face có thể cho phép các tác nhân đe dọa leo thang đặc quyền, giành quyền truy cập của nhiều người thuê vào mô hình của khách hàng khác và thậm chí đảm nhận việc tích hợp liên tục và triển khai liên tục đường ống (CI/CD).

Các nhà nghiên cứu kết luận: “Các mô hình độc hại gây ra rủi ro lớn cho các hệ thống AI, đặc biệt là đối với các nhà cung cấp dịch vụ AI vì những kẻ tấn công có thể tận dụng các mô hình này để thực hiện các cuộc tấn công giữa nhiều người thuê”.

Các chuyên gia cũng cho biết thêm: "Tác động tiềm tàng là rất nghiêm trọng, vì những kẻ tấn công có thể truy cập vào hàng triệu mô hình và ứng dụng AI riêng tư được lưu trữ trong các nhà cung cấp dịch vụ AI”.

Hà Phương